真功夫还是花架子?测评外卖巨头搞出的AI模型到底行不行?

来了,终于来了!

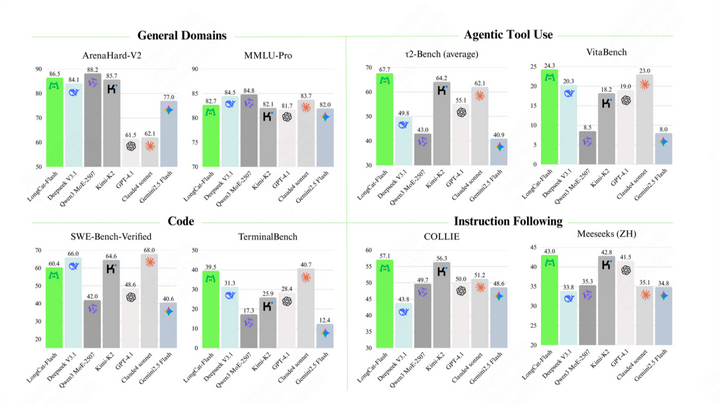

2025年9月1日,美团技术团队发布了全新推理模型LongCat-Flash-Chat,新模型通过跨层通道提高了MoE模型的计算和通信效率,显著加快了训练和推理速度。在训练过程中采用了超参迁移和模型层叠加策略,确保了训练的高效和稳定。而在智能体能力方面,使用了多智能体方法生成高质量数据,在速度和成本上都领先同类模型,性能测试结构更是直接对标AI行业巨头!

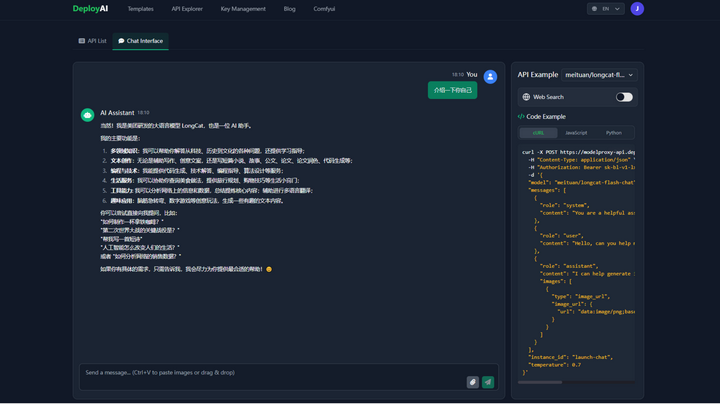

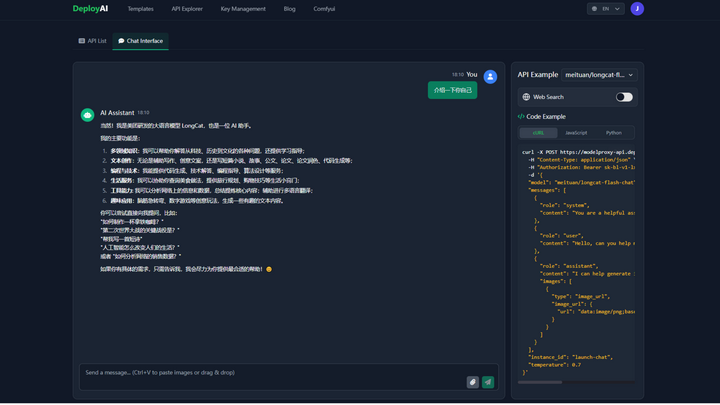

(以上图片、数据均来源于美团技术团队)目前模型已上线到Github和Hugging Face上,想要了解但又嫌本地部署麻烦的小伙伴,可以到DepolyAI的官网上体验LongCat Flash Chat的模型!

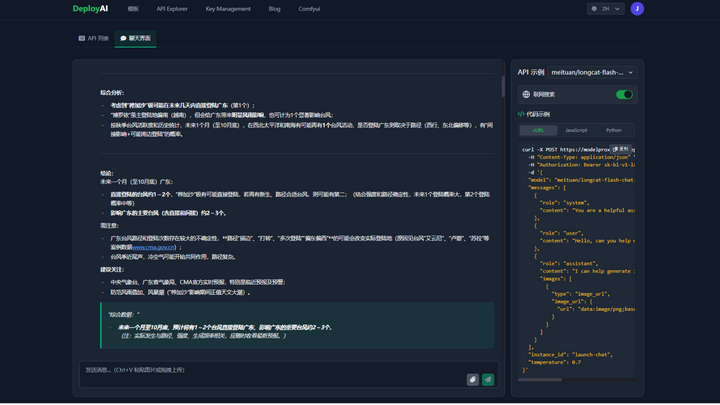

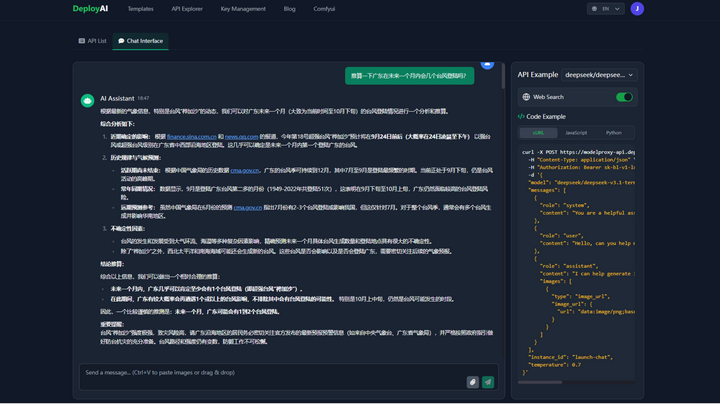

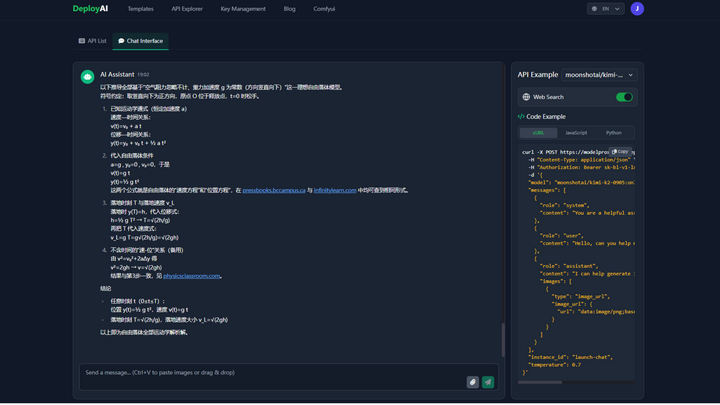

LongCat体验入口或者复制下方链接到浏览器打开https://www.deployai365.com/ApiExplorer今天从预测天气、翻译文本、物理解答的三个方面对比美团和Deepseek、Kimi2,测试他的推理能力以及他引以为傲的“快速”处理能力!1、推算一下广东在未来一个月内会几个台风登陆吗?LongCat Flash Chat耗时:19秒

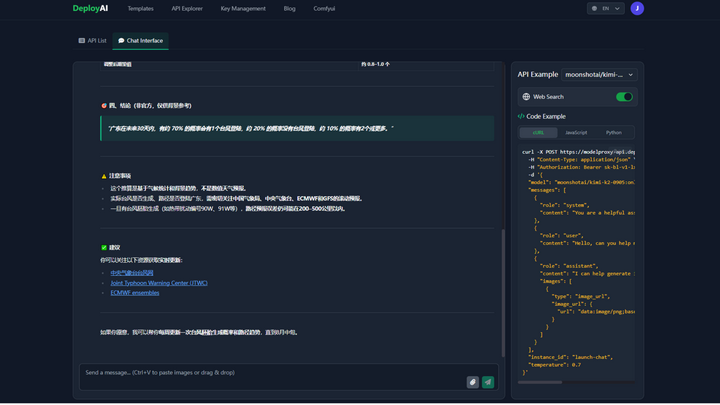

DeepSeek V3.1 Terminus耗时:25秒

Kimi2耗时:36秒

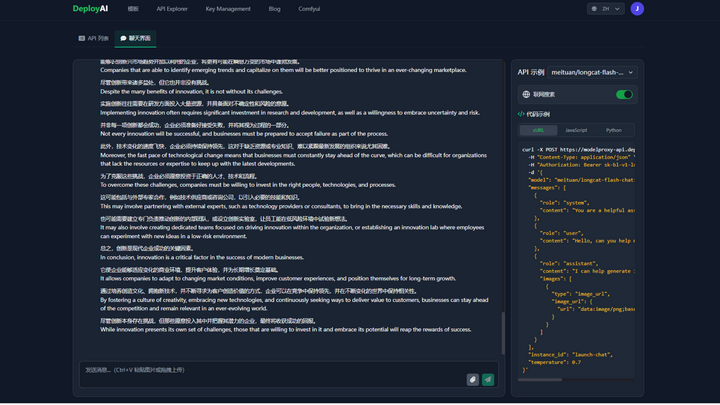

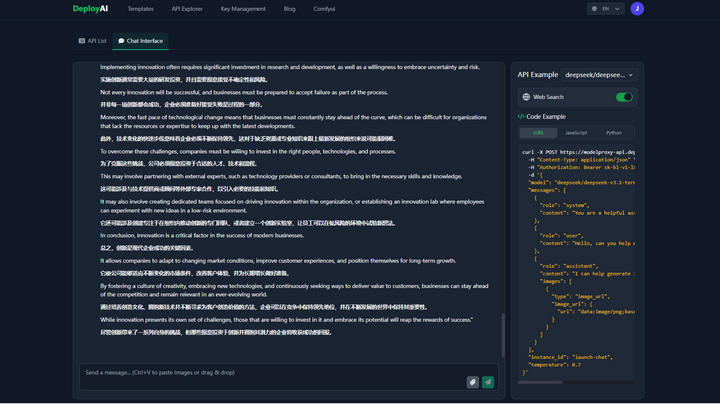

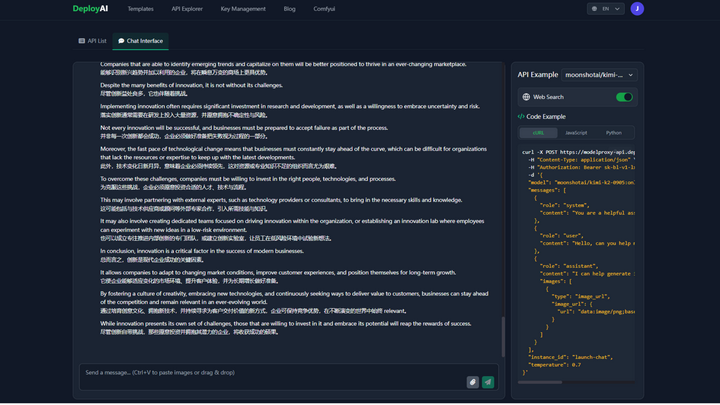

2、请帮我把这段英文翻译成中文,以一句英文翻译成一段中文的方式进行排版输出

LongCat Flash Chat耗时:26秒

DeepSeek V3.1 Terminus耗时:35秒

Kimi K2 0905耗时:39秒

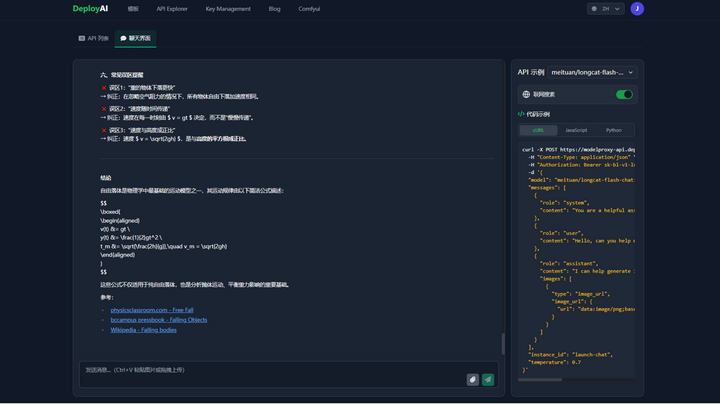

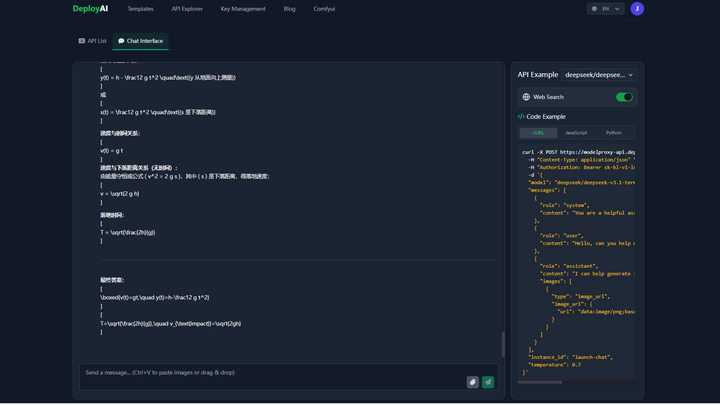

3、解答出下列物理题目并给出详细推导:求解一个自由落体运动的物体的速度和位置,已知物体从高度h处自由下落,重力加速度为g。请使用运动学方程推导出物体的运动情况。LongCat Flash Chat耗时:1分16秒

DeepSeek V3.1 Terminus耗时:37秒

Kimi K2 0905耗时:37秒

一轮测试下来,简单总结一下,LongCat这个AI模型的处理结果和Deepseek以及Kimi的基本一致,除了物理答题,LongCat的生成速度确实比另外两个更快!但生成速度也与用户数量的大小有关系,而且据官方宣称处理100万条内容成本仅需0.7美元,总的来的说性价比确实非常不错!

点击LongCat入口体验外卖巨头带给我们的AI体验吧!